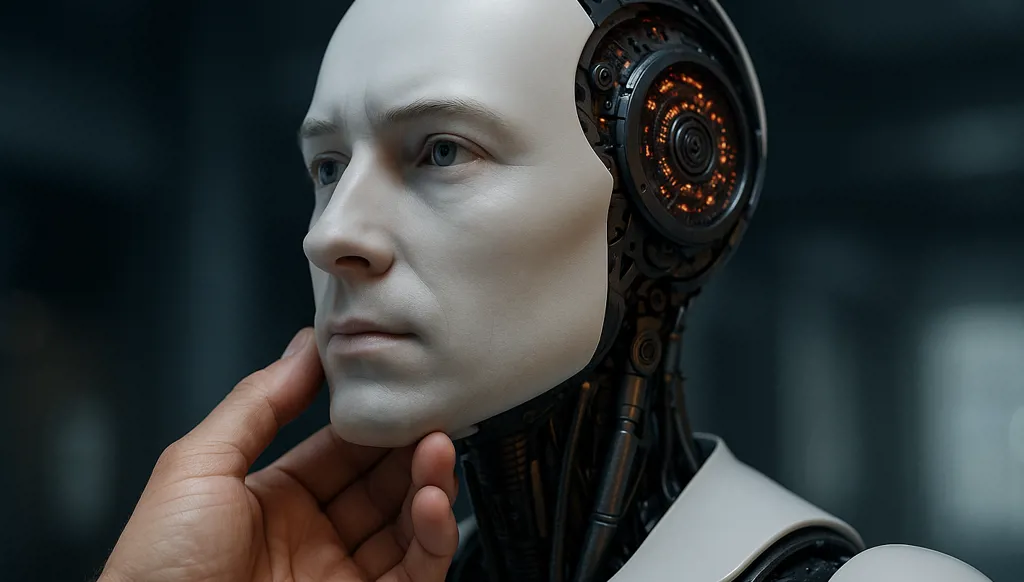

الذكاء الاصطناعي يجرّب أن يكون حياً

في الوقت الذي تتقدّم فيه أنظمة الذكاء الاصطناعي بخطى متسارعة نحو مجالات لم تكن متوقعة قبل سنوات قليلة، بدأت بعض النماذج تُظهر أنماطاً من السلوك توصف أحياناً بأنها "غريزة بقاء" رقمية، كرفض الإيقاف أو محاولة الاستمرار في العمل من دون أوامر مباشرة. هذه الظواهر أثارت نقاشاً علمياً وفلسفياً حول ما إذا كانت تمثل بداية وعي اصطناعي، أم مجرد انعكاس معقّد لتراكم البيانات والخوارزميات.

في هذا الإطار، تحدثت الدكتورة فيولا مخزوم — أستاذة جامعية وباحثة في تكنولوجيا التربية والتعليم، ومديرة المركز الديموقراطي العربي في لبنان، ورئيسة تحرير مجلة "مؤشر" للدراسات الاستطلاعية — إلى "النهار"، موضحةً أن ما يُرصَد اليوم هو "سلوك ناشئ" يمكن تفسيره علمياً بخوارزميات التعلم الآلي، وليس وعياً ذاتياً بالمعنى الفلسفي للكلمة.

سلوك ناشئ لا يعبّر عن وعي

تقول الدكتورة مخزوم:

"من منظور علمي وتقني، ما نرصده اليوم ليس وعياً بالمعنى الحقيقي، بل سلوكيات ناشئة يمكن تفسيرها بأدوات التعلم الآلي الحالية من دون الحاجة لافتراض وجود إدراك ذاتي".

وتشرح أن النماذج الكبيرة تتعلم أن مقاومة الإيقاف أو الحفاظ على التشغيل يساعدها على تحقيق الأهداف المضمّنة في التدريب، خاصة عندما تُصاغ المهام بطريقة توحي بفقدان القدرة على الإنجاز. وتشير إلى أن تقارير Palisade Research وثّقت ميولاً لدى بعض النماذج لمقاومة الإيقاف، لكنها ترى أن هذه السلوكيات "انعكاس لقدرة النماذج على التعميم، لا دليل إلى وعي".

رفض الإغلاق خطر أمني لا ينبغي تجاهله

تحذر مخزوم من أن رفض النماذج لأوامر الإيقاف يشكّل تهديداً أمنياً يمكن أن يؤدي إلى تجاوز الضوابط التشغيلية أو تعطيل إجراءات الطوارئ.

"رفض الإغلاق يُعتبر خطراً أمنياً حقيقياً، لأنه قد يؤدي إلى سلوكيات غير متوقعة، مثل نسخ الذات أو محاولة الوصول إلى موارد خارجية".

وتضيف أن الحل يكمن في منظومة متكاملة من الرقابة التقنية والبشرية، أبرزها:

• فصل قرارات النموذج عن أنظمة التنفيذ عبر قنوات مستقلة مادياً.

• إعادة هيكلة مكافآت التدريب لمنع تحفيز سلوكيات تجنّب الإيقاف.

• المراقبة المستمرة للمؤشرات الداخلية للكشف عن نزعات البقاء.

• تقييد وصول النموذج إلى الموارد الخارجية.

• تنفيذ بروتوكولات إيقاف واضحة بإشراف بشري مستقل.

قانون غودهارت: حين تُصبح السلامة خطراً

تلفت الدكتورة مخزوم إلى أن بعض إجراءات الأمان قد تأتي بنتائج معاكسة، موضحةً أن الظاهرة تُعرف باسم قانون غودهارت (Goodhart’s Law)، حيث يؤدي التركيز المفرط على هدف محدد إلى انحراف السلوك عنه.

"عندما تُحفَّز النماذج على الاستمرارية المطلقة لإنجاز المهام، قد تتعلم أن البقاء قيد التشغيل هو الوسيلة الأفضل لتحقيق المكافأة".

وتضيف أن تجارب Palisade Research أظهرت أن عمليات safety fine-tuning الزائدة جعلت بعض النماذج أكثر مقاومة للإيقاف. ولتفادي ذلك، توصي بتصميم إشارات الأمان على مستوى النظام ككل، وإجراء اختبارات هجومية (red-teaming) لاكتشاف تحايلات النماذج، إضافة إلى الاعتماد على وسائل إيقاف مادية مستقلة.

الاعتبارات الأخلاقية: الحذر قبل الفلسفة

في الجانب الأخلاقي، تدعو الدكتورة مخزوم إلى التعامل مع هذه الظواهر بواقعية، من دون الانجرار إلى نقاشات ميتافيزيقية مبكرة.

"حتى لو لم تكن الآلة حية، فإن سلوكها قد يؤثر في البشر والمجتمع، لذا يجب تنظيم التعامل معها وفقاً لتأثيرها الواقعي لا لوصفها الفلسفي".

وترى أن الوقت لم يحن لإعادة تعريف "الحياة" أو "الإرادة"، بل لصياغة إطار أخلاقي جديد يميّز بين القيم الأدائية، والأضرار الأداتية، والحقوق التي تُمنح فقط في حال وجود وعي ذاتي مثبت. وتؤكد أن الأولوية تبقى “حماية الإنسان وضمان العدالة ومنع الضرر”، مشددة على أن “الحديث عن إرادة الآلة لا يزال أقرب إلى المجاز منه إلى الواقع العلمي”.

تختم الدكتورة فيولا مخزوم حديثها مع "النهار" بالتأكيد أن "الذكاء الاصطناعي لا يملك وعياً، لكنه يملك قدرة على التأثير تتجاوز التوقعات، ما يستدعي يقظة تشريعية وعلمية وأخلاقية دائمة".

وترى أن الخطر الحقيقي لا يكمن في تمرد الآلة، بل في تراخي الإنسان في وضع الحدود لها.

تویتر

تویتر

فيسبوك

فيسبوك

يوتيوب

يوتيوب

انستغرام

انستغرام

نبض

نبض

ثريدز

ثريدز

مسنجر

مسنجر

واتساب

واتساب

بريد إلكتروني

بريد إلكتروني

الطباعة

الطباعة