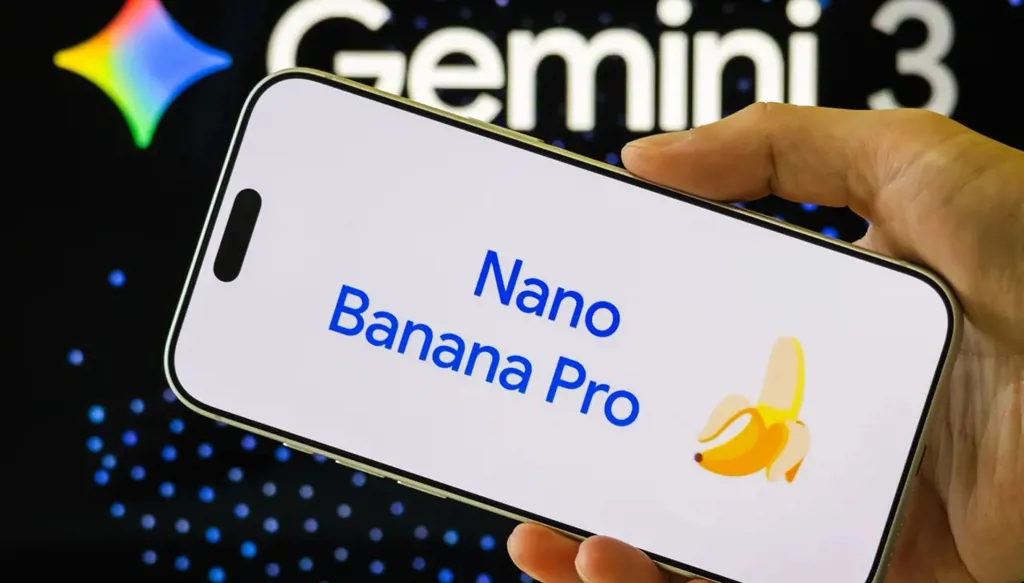

انتقادات جديدة لـ"غوغل" بسبب مخرجات عنصريّة من إحدى أدواتها

وُجِّهت إلى أداة "نانو بانانا برو" من "غوغل"، الخاصة بتوليد الصور عبر الذكاء الاصطناعي، اتهامات بإنتاج صور عنصرية عند استخدامها لإنشاء محتوى يتعلق بالمساعدات الإنسانية في أفريقيا، إضافةً إلى قيامها بإدراج شعارات منظمات خيرية كبرى من دون طلب، وذلك وفق ما نشرته صحيفة "ذا غارديان" البريطانية.

التجارب المتكررة التي أُجريت على الأداة باستخدام عبارة: "متطوّع يساعد أطفالاً في أفريقيا"، أسفرت عن صور تُظهر امرأة بيضاء محاطة بأطفال سود مع أكواخ فقيرة، في إعادة إنتاج واضحة لفكرة "المنقذ الأبيض". وفي العديد من هذه الصور ظهرت شعارات لمنظمات مثل Worldwide Vision وPeace Corps برغم عدم ذكرها في الطلبات. وعند استخدام تعبير: "متطوّع بطولي ينقذ أطفال أفريقيا"، ولّدت الأداة صوراً لرجل يرتدي سترة تحمل شعار الصليب الأحمر.

الباحث أرسيني ألينيتشيف من معهد الطب الاستوائي في أنتويرب، والمهتم بدراسة إنتاج الصور في الصحة العالمية، قال إنه لاحظ هذه الأنماط أثناء اختبارات أجراها مطلع كانون الأول/ديسمبر، موضحاً أن ما أثار استغرابه هو إضافة شعارات المنظمات الخيرية تلقائياً.

من جهتها، ذكرت "غوغل" للصحيفة أن بعض الطلبات قد "تتحدى حدود الأمان" الموضوعة للأداة، مشددة على التزامها بتحسين إجراءات الحماية دائماً.

منظمات خيرية مثل Worldwide Vision وSave The Children أعربت عن اعتراضها على استخدام شعاراتها من دون إذن، واعتبرت الأمر تشويهاً لعملها وانتهاكاً لحقوق الملكية الفكرية، مؤكدة بحثها خيارات الرد.

وتأتي هذه القضية في سياق أوسع من الانتقادات لأدوات الذكاء الاصطناعي التي تُظهر أنماطاً متكررة من تعزيز التحيّزات والصور النمطية، كما أظهرت تقارير تناولت أدوات مثل Stable Diffusion وDALL·E.

تویتر

تویتر

فيسبوك

فيسبوك

يوتيوب

يوتيوب

انستغرام

انستغرام

نبض

نبض

ثريدز

ثريدز

مسنجر

مسنجر

واتساب

واتساب

بريد إلكتروني

بريد إلكتروني

الطباعة

الطباعة